In der heutigen datengetriebenen Welt ist der Zugriff auf und die effiziente Verarbeitung von großen Datenmengen entscheidend. In diesem Blogbeitrag erfahren Sie, wie wir bei IT-WINGS Google Analytics 4 (GA4) Daten mit Python Pandas aufbereiten und wichtige Key Performance Indicators (KPIs) mit Pandasql berechnen. Außerdem begründen wir die Nutzung von Pandasql und zeigen die Berechnung der Conversion Rate als Beispiel eines KPI.

1. Datenbeschaffung aus BigQuery

BigQuery ist eine leistungsstarke Plattform zur Verarbeitung von Big Data. Alle Rohdaten aus GA4, die als Grundlage für unsere Analysen dienen, erhalten wir über den Export aus BigQuery. Um mit den Rohdaten in Python weiterzuarbeiten, werden die Daten nach dem Export über eine API abgefragt. Mehr Informationen zu dem Verfahren erhalten Sie in unserem Blogartikel Einführung in Google BigQuery.

2. Datenbereinigung und Preprocessing mit Pandas

Die Daten, die wir erhalten, sind roh und unstrukturiert. Für die Bereinigung und Aufbereitung der Daten nutzen wir Pandas. Die Pandas-Funktionen können zum Beispiel für Folgendes genutzt werden:

- Entfernung von unnötigen Daten

- Ergänzung wichtiger Daten

- Verbindung wichtiger Daten

Diese Vorbereitungen sind für spätere Analysen entscheidend.

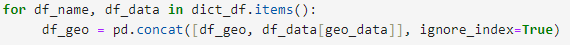

Beispiel der Verwendung einer Pandas-Funktion, zum Konkatenieren zweier DataFrames:

Hier finden Sie eine Auflistung aller Funktionen von Pandas.

3. Daten aufspalten für die Performance-Optimierung

IT-WINGS GOLD

Einige Inhalte sind nur über ein kostenloses Abonnement zugänglich. Entdecken Sie alle unsere umfassenden Inhalte zu den Themen Datenanalyse und Verbesserung Ihrer Strategien.